Comprender la diferencia entre bots de búsqueda y raspadores es essential para search engine optimization.

Los rastreadores del sitio net caen en dos categorías:

- Bots de primera fiesta, que usa para auditar y optimizar su propio sitio.

- Bots de terceros, que rastrean su sitio externamente, a veces para indexar su contenido (como GoogleBot) y otros tiempos para extraer datos (como raspadores de la competencia).

Esta guía desglose los rastreadores de primera parte que pueden mejorar su sitio search engine optimization técnico y bots de terceros, explorando su impacto y cómo manejarlos de manera efectiva.

Crawlers de terceros: Insights mineros de su propio sitio net

Los rastreadores pueden ayudarlo a identificar formas de mejorar su search engine optimization técnico.

Mejorar la base técnica de su sitio, la profundidad arquitectónica y la eficiencia de rastreo es una estrategia a largo plazo para aumentar el tráfico de búsqueda.

Ocasionalmente, puede descubrir problemas importantes, como un archivo robots.txt que bloquea todos los bots de búsqueda en un sitio de puesta en escena que se dejó activo después del lanzamiento.

La reparación de tales problemas puede conducir a mejoras inmediatas en la visibilidad de búsqueda.

Ahora, exploremos algunas tecnologías basadas en rastreo que puede usar.

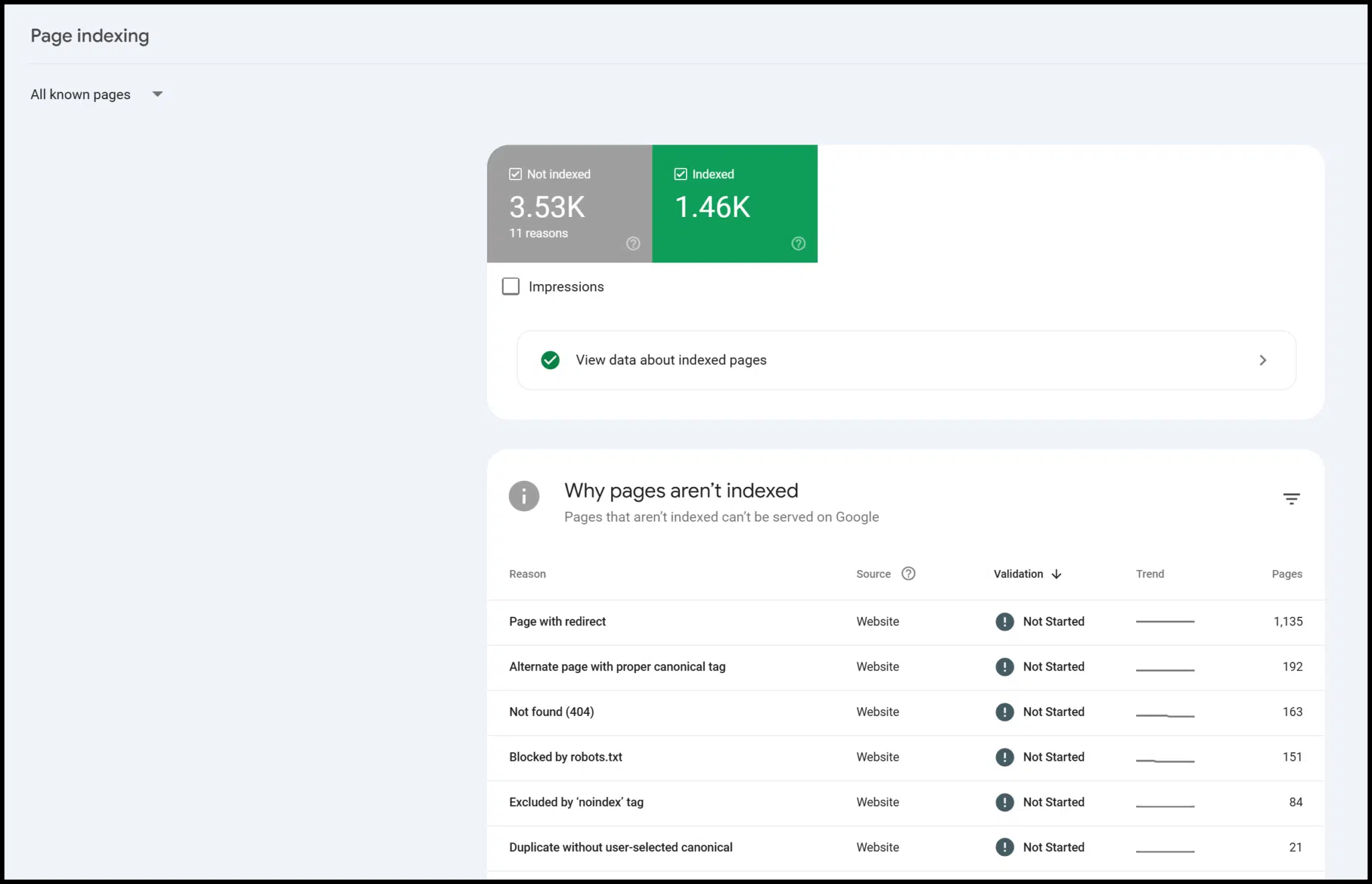

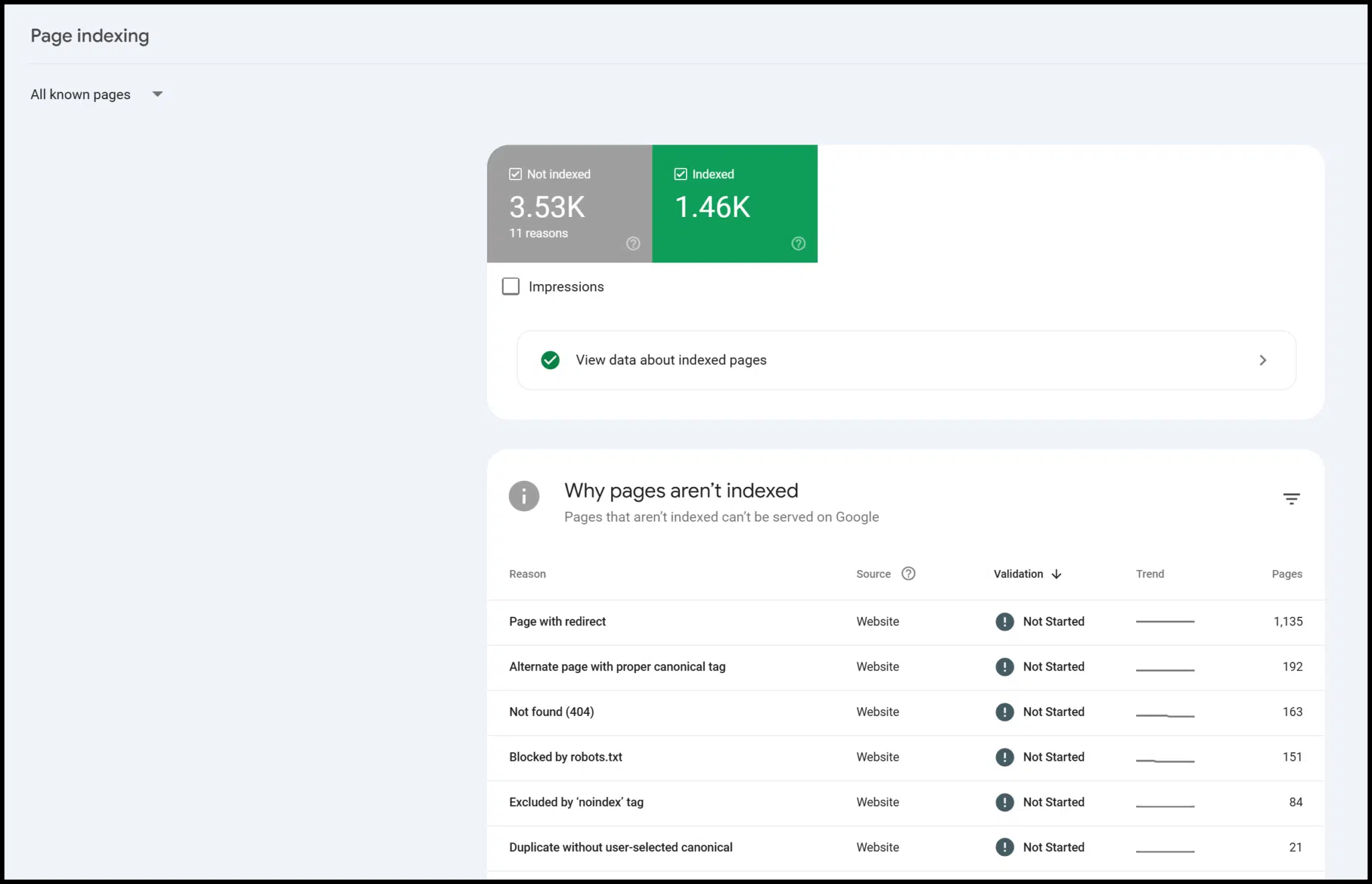

Googlebot a través de la consola de búsqueda

No trabaja en un centro de datos de Google, por lo que no puede iniciar GoogleBot para rastrear su propio sitio.

Sin embargo, verificando su sitio con Consola de búsqueda de Google (GSC), puede acceder a los datos y las concepts de GoogleBot. (Seguir Guía de Google para colocarte en la plataforma).

GSC es de uso gratuito y proporciona información valiosa, especialmente sobre la indexación de páginas.

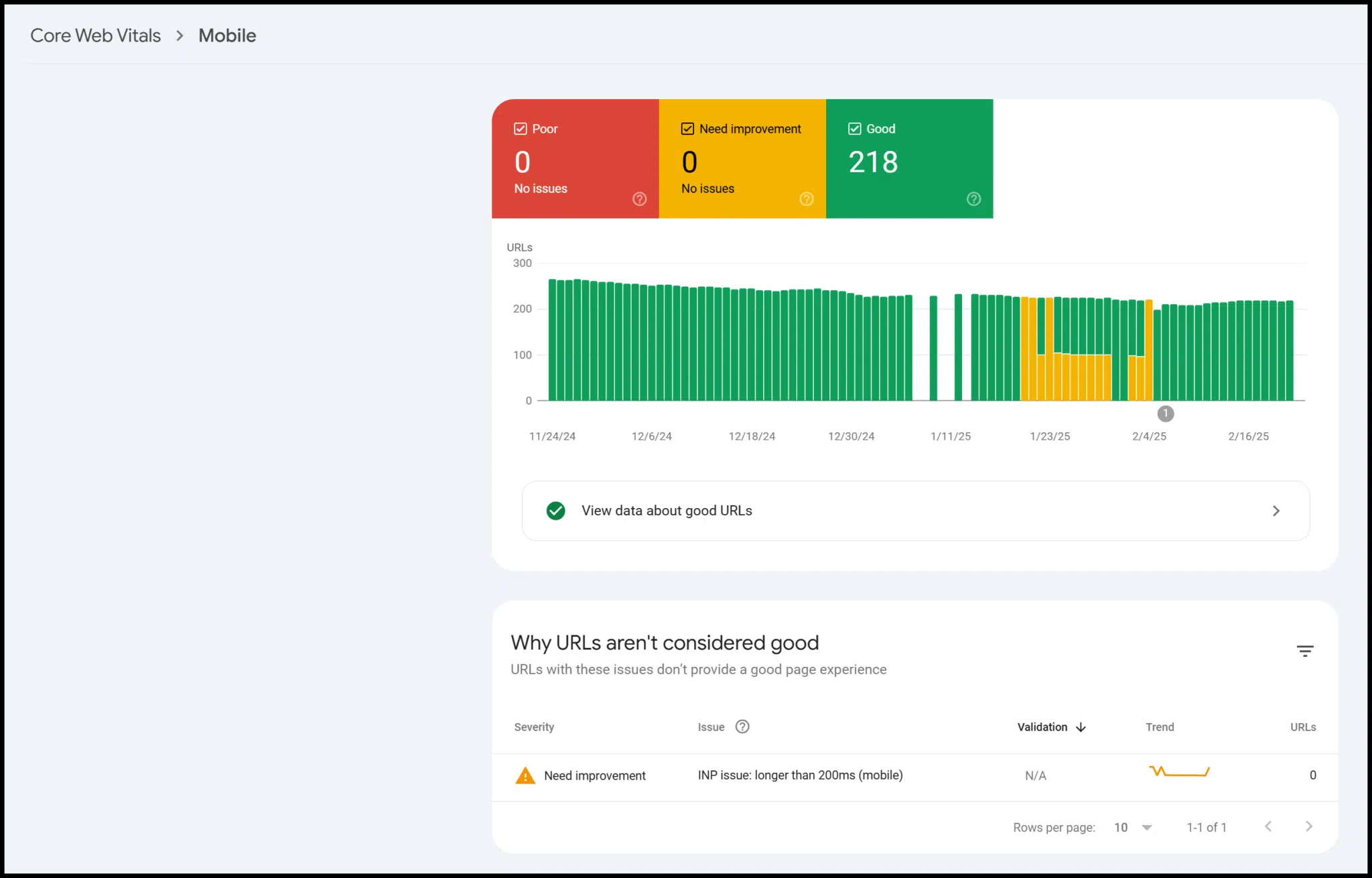

También hay datos sobre la facilidad móvil, datos estructuradosy Core Net Sitals:

Técnicamente, estos son datos de terceros de Google, pero solo los usuarios verificados pueden acceder a él para su sitio.

En la práctica, funciona muy como los datos de un rastreo que ejecuta usted mismo.

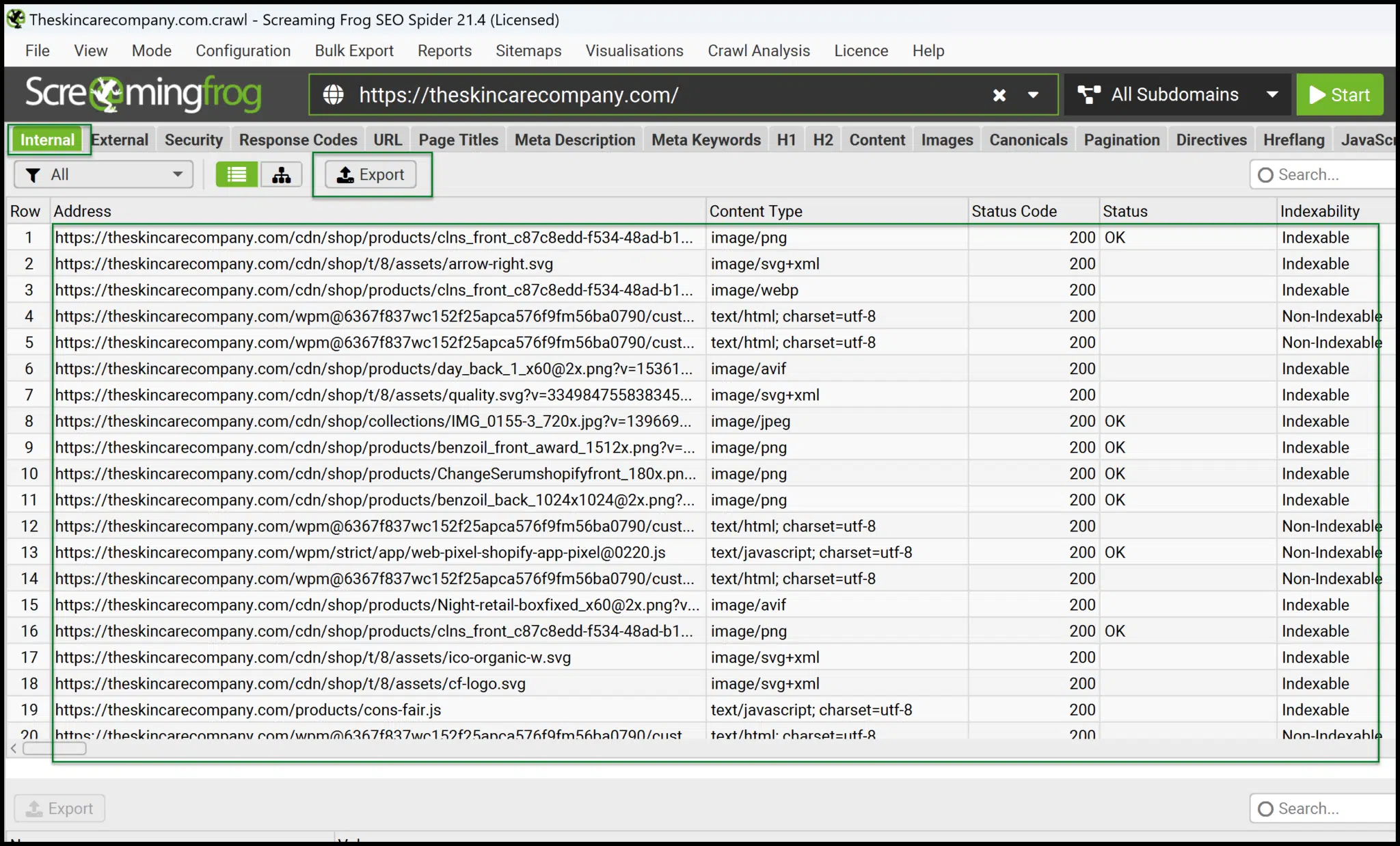

Spider de search engine marketing de rana gritando

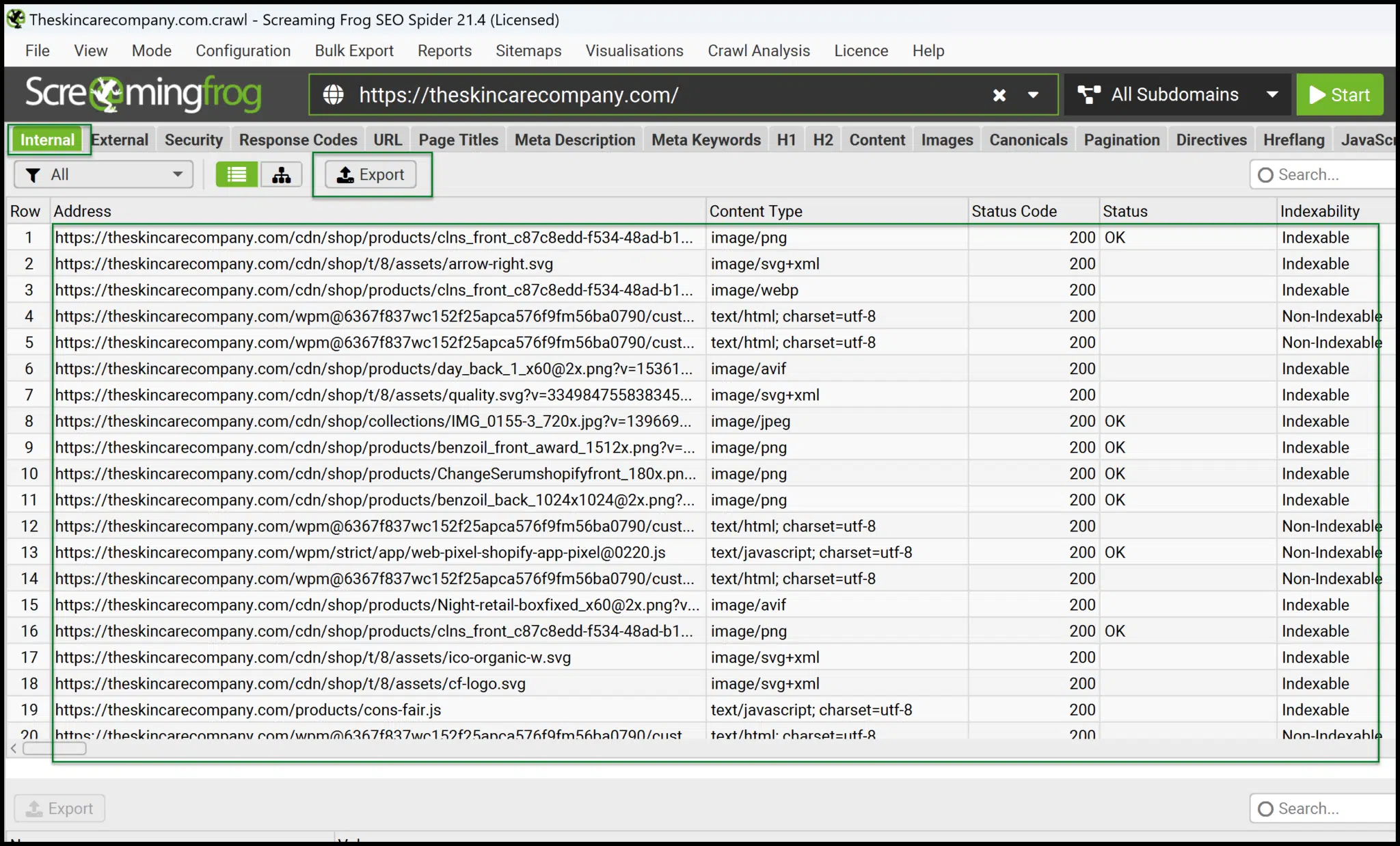

Screaming Frog es una aplicación de escritorio que se ejecuta localmente en su máquina para generar datos de rastreo para su sitio net.

También ofrecen un analizador de archivos de registro, que es útil si tiene acceso a los archivos de registro del servidor. Por ahora, nos centraremos en gritar la araña Search engine marketing de Frog.

A $ 259 por año, es altamente rentable en comparación con otras herramientas que cobran tanto por mes.

Sin embargo, debido a que se ejecuta localmente, se detiene si apaga su computadora, no funciona en la nube.

Aún así, los datos que proporciona son rápidos, precisos e ideales para aquellos que desean sumergirse más profundamente en el search engine optimization técnico.

Desde la interfaz principal, puede iniciar rápidamente sus propios rastreos.

Una vez completado, exportación Interno> todos los datos a un formato legible con Excel y siéntete cómodo manejando y girando los datos para obtener información más profunda.

Screaming Frog también ofrece muchas otras opciones de exportación útiles.

Proporciona informes y exportaciones para la vinculación interna, redireccionamiento (incluidas las cadenas de redirección), el contenido inseguro (contenido mixto) y más.

El inconveniente es que requiere más administración práctica, y deberá sentirse cómodo trabajando con datos en Excel o Google Sheets para maximizar su valor.

Cavar más profundamente: 4 de las mejores herramientas técnicas de search engine optimization

Auditoría del sitio AHREFS

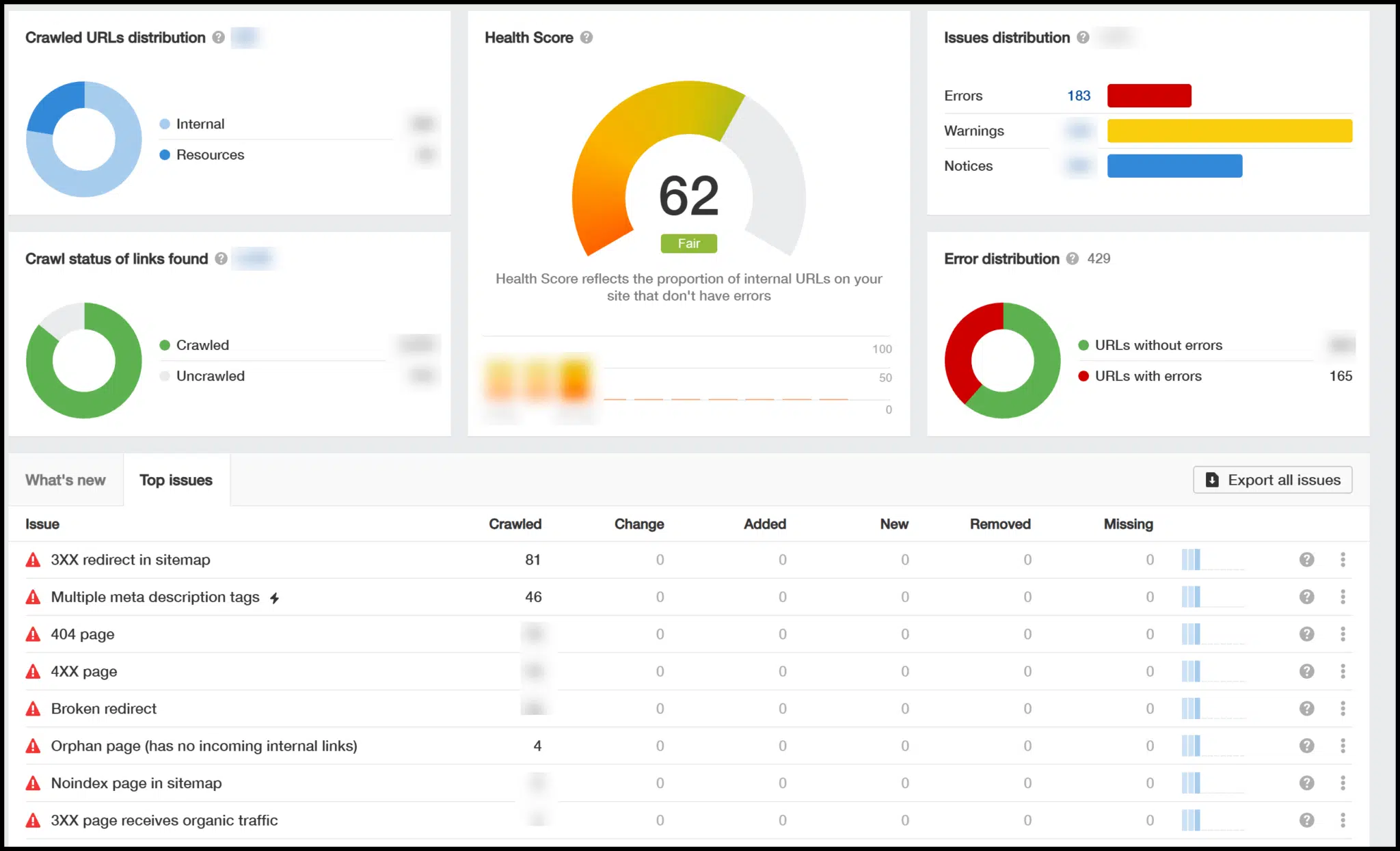

AHREFS es una plataforma integral basada en la nube que incluye un rastreador de search engine optimization técnico dentro de su módulo de auditoría del sitio.

Para usarlo, configure un proyecto, configure los parámetros de rastreo y inicie el rastreo para generar información técnica de search engine optimization.

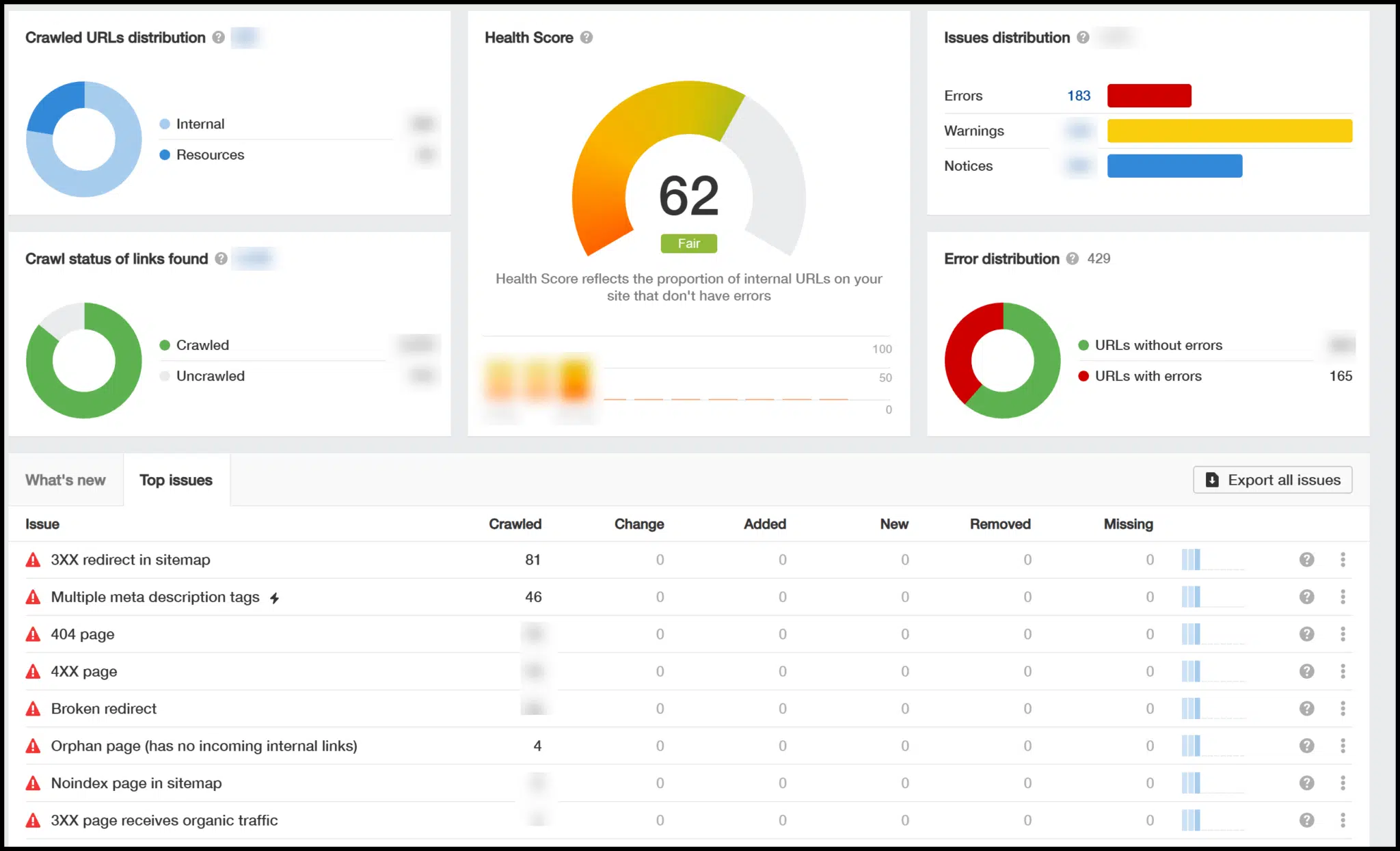

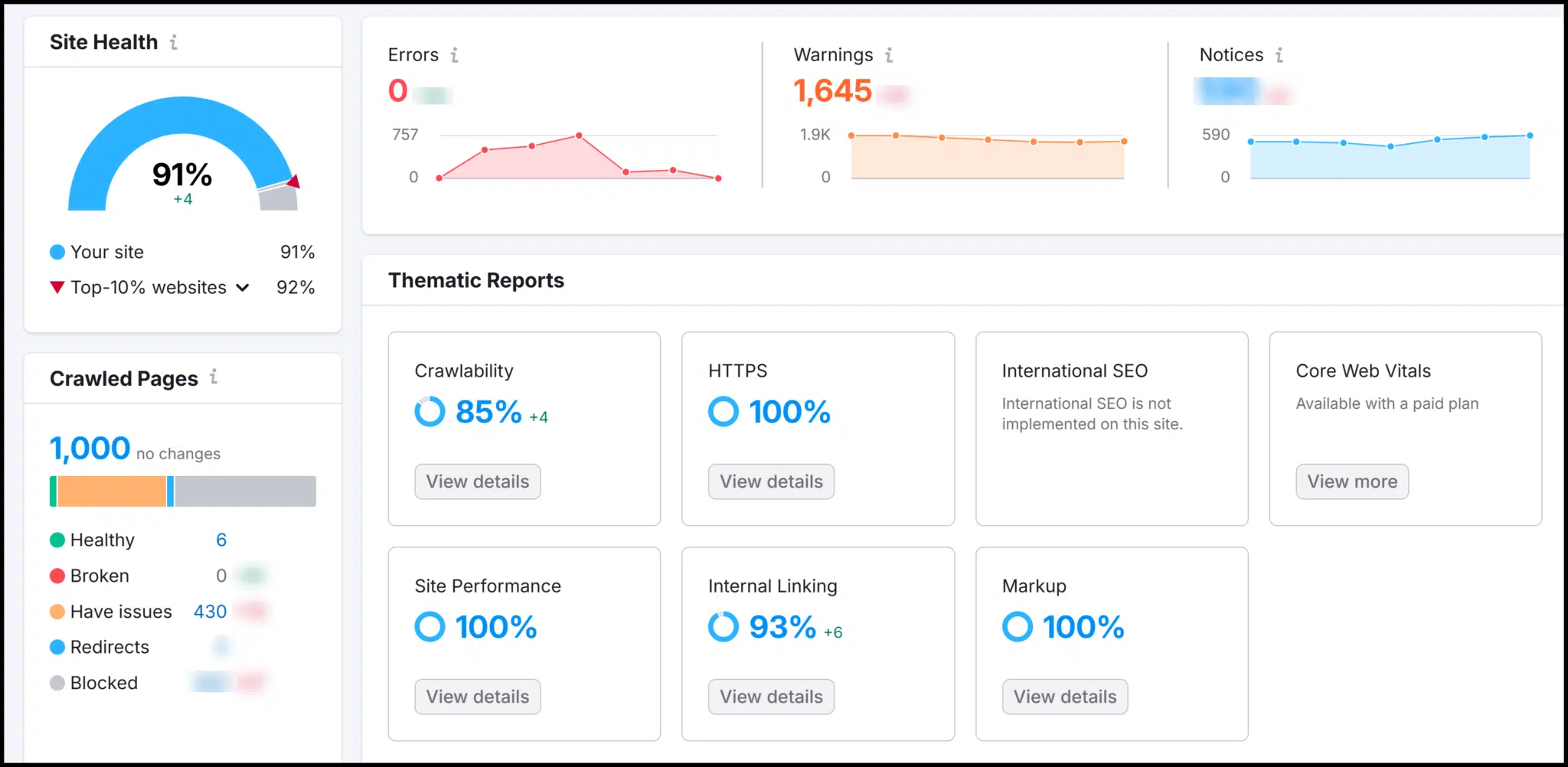

Una vez que se full el rastreo, verá una descripción common que incluye una calificación técnica de salud de search engine optimization (0-100) y destaca los problemas clave.

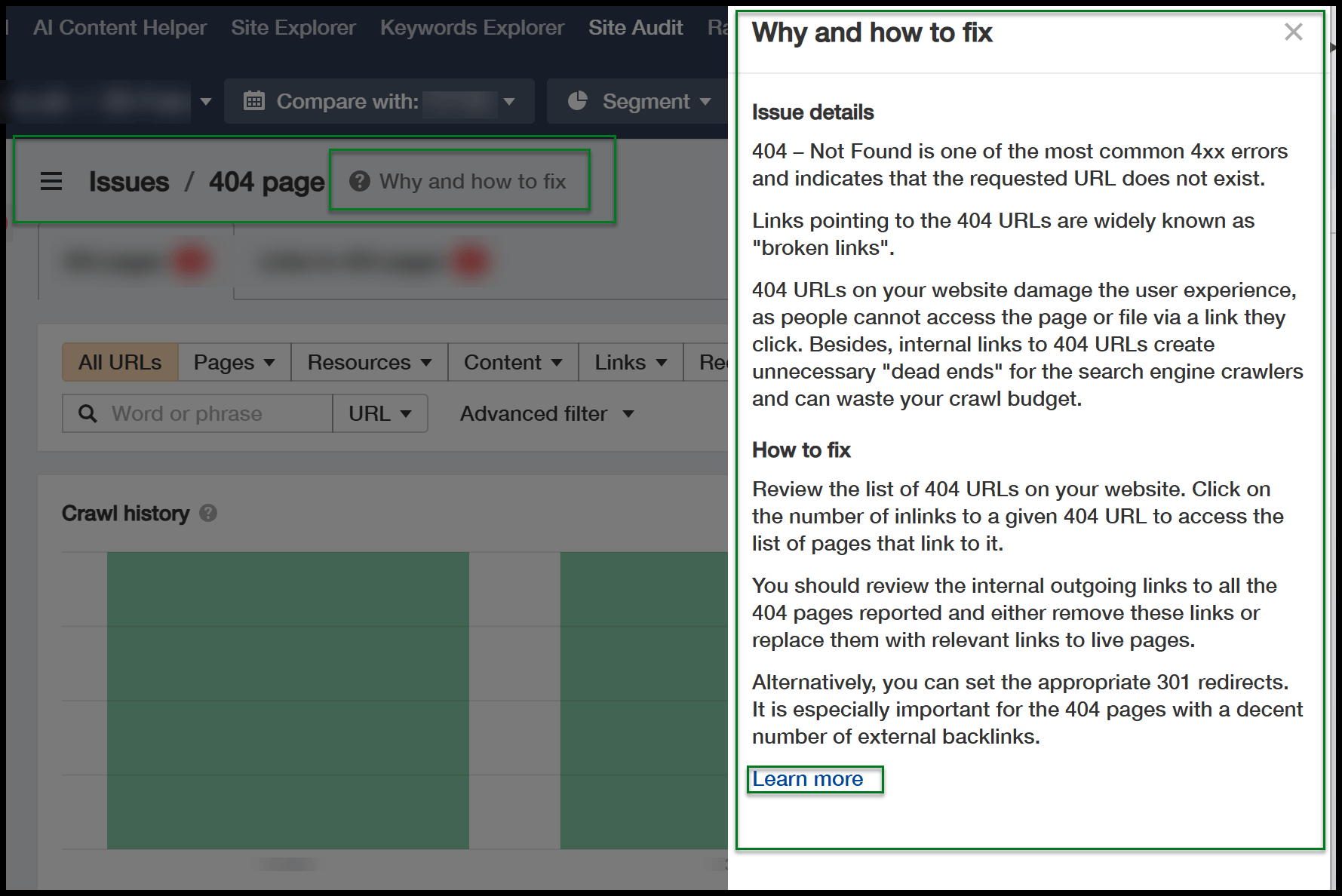

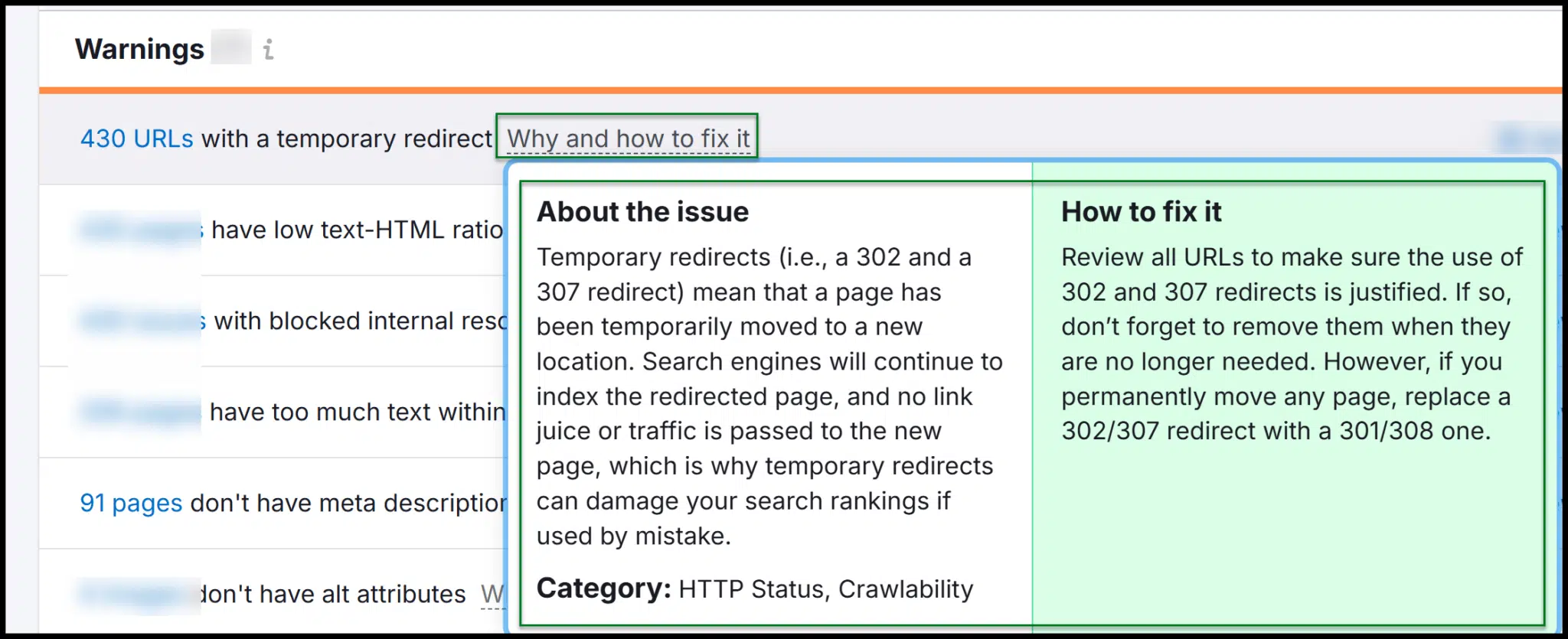

Puede hacer clic en estos problemas para obtener más detalles, y aparece un botón útil a medida que se sumerge más profundamente, explicando por qué se necesitan ciertas correcciones.

Dado que AHREFS se ejecuta en la nube, el estado de su máquina no afecta el rastreo. Continúa incluso si su PC o Mac está apagado.

En comparación con Screaming Frog, AHREFS proporciona más orientación, lo que hace que sea más fácil convertir los datos de rastreo en información de search engine optimization procesable.

Sin embargo, es menos rentable. Si no necesita sus características adicionales, como datos de vínculo de retroceso e investigación de palabras clave, es posible que no valga la pena el gasto.

Auditoría del sitio SEMRUSH

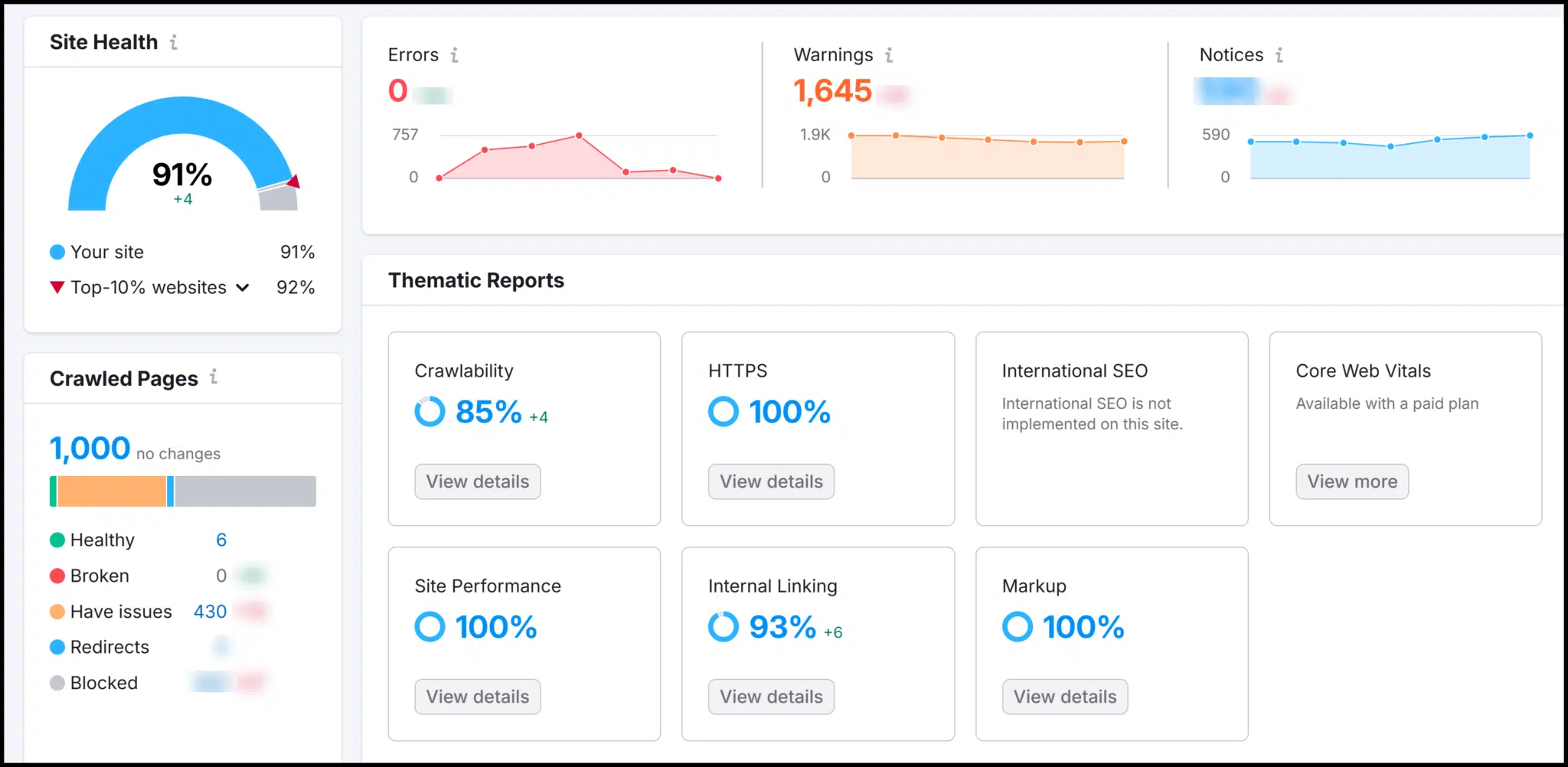

El siguiente es Semrush, otra poderosa plataforma basada en la nube con un rastreador de search engine optimization técnico incorporado.

Al igual que AHREFS, también proporciona análisis de vínculo de retroceso y herramientas de investigación de palabras clave.

SEMRUSH ofrece una calificación técnica de salud de search engine optimization, que mejora a medida que soluciona los problemas del sitio. Su descripción common de rastreo destaca los errores y las advertencias.

Mientras explora, encontrará explicaciones de por qué se necesitan correcciones y cómo implementarlas.

Tanto SEMRUSH como AHREFS tienen herramientas de auditoría de sitio robustas, lo que facilita el lanzamiento de rastreo, analizar datos y proporcionar recomendaciones a los desarrolladores.

Si bien ambas plataformas son más caras que gritos de rana, se destacan al convertir los datos de rastreo en concepts procesables.

SEMRUSH es un poco más rentable que los ahrefs, lo que lo convierte en una opción sólida para aquellos nuevos en search engine optimization técnico.

Obtenga la búsqueda del boletín en los que los especialistas en advertising and marketing confíen.

Crawlers de terceros: bots que podrían visitar su sitio net

Anteriormente, discutimos cómo los terceros podrían rastrear su sitio net por varias razones.

Pero, ¿qué son estos rastreadores externos y cómo puede identificarlos?

Googlebot

Como se mencionó, puede usar la consola de búsqueda de Google para acceder a algunos de los datos de rastreo de Googlebot para su sitio.

Sin Googlebot que arrastrara su sitio, no habría datos para analizar.

(Puede obtener más información sobre los bots de rastreo comunes de Google en este Buscar documentación central.)

Los rastreadores más comunes de Google son:

- Teléfono inteligente de Googlebot.

- Escritorio de Googlebot.

Cada uno utiliza motores de renderizado separados para dispositivos móviles y de escritorio, pero ambos contienen “Googlebot/2.1“En su cadena de agente de usuario.

Si analiza su registros de servidorpuede aislar el tráfico de Googlebot para ver qué áreas de su sitio se arrastra con mayor frecuencia.

Esto puede ayudar a identificar problemas técnicos de search engine optimization, como páginas que Google no se arrastra como se esperaba.

Para analizar los archivos de registro, puede crear hojas de cálculo para procesar y pivotar los datos de los archivos .txt o .csv sin procesar. Si eso parece complejo, el analizador de archivos de registro de Screaming Frog es una herramienta útil.

En la mayoría de los casos, no debe bloquear Googlebot, ya que esto puede afectar negativamente el search engine optimization.

Sin embargo, si GoogleBot se atasca en una arquitectura de sitio altamente dinámica, es posible que deba bloquear URL específicas a través de robots.txt. Use esto cuidadosamente: el uso excesivo puede dañar su clasificación.

TRÁFICO FINALES DE GOOGLEBOT

No todo el tráfico que afirma ser Googlebot es legítimo.

Muchos rastreadores y raspadores permiten a los usuarios falsificar las cadenas de agentes de usuario, lo que significa que pueden disfrazarse de Googlebot para evitar las restricciones de rastreo.

Por ejemplo, la rana de gritos se puede configurar para hacerse pasar por Googlebot.

Sin embargo, muchos sitios net, especialmente aquellos alojados en grandes redes en la nube como AWS, pueden diferenciar entre el tráfico actual y falsa de Googlebot.

Lo hacen verificando si la solicitud proviene de los rangos IP oficiales de Google.

Si una solicitud cube ser Googlebot pero se origina fuera de esos rangos, es possible que sea falso.

Otros motores de búsqueda

Además de Googlebot, otros motores de búsqueda pueden rastrear su sitio. Por ejemplo:

- Bingbot (Microsoft Bing).

- Duckduckbot (Duckduckgo).

- Yandexbot (Yandex, un motor de búsqueda ruso, aunque no bien documentado).

- Baiduspider (Baiduun motor de búsqueda widespread en China).

En su archivo robots.txt, puede crear reglas comodín para no permitir todos los bots de búsqueda o especificar reglas para rastreadores y directorios particulares.

Sin embargo, tenga en cuenta que las entradas robots.txt son directivas, no comandos, lo que significa que pueden ser ignorados.

A diferencia de las redirecciones, que evitan que un servidor sirva un recurso, Robots.txt es simplemente una señal fuerte que solicita a los bots para no rastrear ciertas áreas.

Algunos rastreadores pueden ignorar por completo estas directivas.

Gritando el bot de rana de rana

Gritar rana generalmente se identifica con un agente de usuarios como Screaming Frog search engine optimization Spider/21.4.

El texto de “Spider de search engine optimization de rana gritando” siempre se incluye, seguido del número de versión.

Sin embargo, Screaming Frog permite a los usuarios personalizar la cadena de agente de usuario, lo que significa que los rastreos pueden parecer de Googlebot, Chrome u otro agente de usuario.

Esto hace que sea difícil bloquear los risas de rana gritos.

Si bien puede bloquear los agentes de usuarios que contienen “Spider de search engine optimization de rana gritando”, un operador simplemente puede cambiar la cadena.

Si sospecha que el rastreo no autorizado, es posible que deba identificar y bloquear el rango de IP.

Esto requiere una intervención del lado del servidor desde su desarrollador net, ya que robots.txt no puede bloquear IPS, especialmente porque la rana gritos se puede configurar para ignorar las directivas robots.txt.

Sin embargo, sea cauteloso. Puede ser su propio equipo de search engine optimization que realice un rastreo para verificar los problemas técnicos de search engine optimization.

Antes de bloquear la rana de gritos, intente determinar la fuente del tráfico, ya que podría ser un empleado interno de recopilación de datos.

Ahrefs bots

Ahrefs tiene un bot de rastreo y un bot de auditoría del sitio para gatear.

- Cuando Ahrefs rastree la net para su propio índice, verá el tráfico desde

AhrefsBot/7.0. - Cuando un usuario de AHREFS ejecuta una auditoría del sitio, el tráfico vendrá de

AhrefsSiteAudit/6.1.

Ambos bots respetan los robots.txt rechazar las reglas, según la documentación de AHREFS.

Si no desea que su sitio se rastree, puede bloquear AHREF con robots.txt.

Alternativamente, su desarrollador net puede negar las solicitudes de agentes de usuarios que contienen “AhrefsBot” o “AhrefsSiteAudit“.

Semrush Bot

Al igual que AHREFS, SEMRUSH opera múltiples rastreadores con diferentes cadenas de agentes de usuario.

Asegúrese de revisar toda la información disponible para identificarla correctamente.

Las dos cadenas de agentes de usuario más comunes que encontrarás son:

- Semrushbot: El rastreador net common de SEMRUSH, solía mejorar su índice.

- Siteauditbot: Utilizado cuando un usuario de SEMRUSH inicia una auditoría de sitio.

Rogerbot, Dotbot y otros rastreadores

MOZ, otra plataforma search engine optimization ampliamente utilizada, implementa Rogerbot para rastrear sitios net para obtener información técnica.

MOZ también opera Dotbot, un rastreador net common. Ambos se pueden bloquear a través de su archivo robots.txt si es necesario.

Otro rastreador que puede encontrar es MJ12BOT, utilizado por la Majestic search engine optimization Platform. Por lo common, no es nada de qué preocuparse.

Bots de rastreo que no son de Search engine marketing

No todos los rastreadores están relacionados con search engine optimization. Muchas plataformas sociales operan sus propios bots.

Meta (la empresa matriz de Fb) ejecuta múltiples rastreadores, mientras que Twitter utilizó TwitterBot anteriormente, y es possible que X ahora implementa un sistema comparable, aunque menos documentado,.

Los rastreadores escanean continuamente la net para obtener datos. Algunos pueden beneficiar a su sitio, mientras que otros deben ser monitoreados a través de registros de servidores.

Comprensión de los bots de búsqueda, rastreadores de search engine optimization y raspadores para search engine optimization técnico

La gestión de rastreadores de terceros y de terceros es esencial para mantener el search engine optimization técnico de su sitio net.

Management de llave

- Rastreadores de primera parte (por ejemplo, gritos de rana, ahrefs, semrush) Ayude a auditar y optimizar su propio sitio.

- Googlebot Insights a través de la consola de búsqueda proporciona datos cruciales sobre la indexación y el rendimiento.

- Rastreadores de terceros (por ejemplo, Bingbot, Ahrefsbot, Semrushbot) Ratea su sitio para la indexación de búsqueda o el análisis competitivo.

- Gestión de bots a través de robots.txt y los registros de servidor pueden ayudar a controlar rastreadores no deseados y mejorar la eficiencia de rastreo en casos específicos.

- Habilidades de manejo de datos son cruciales para extraer información significativa de los informes de rastreo y los archivos de registro.

Al equilibrar la auditoría proactiva con la gestión de botes estratégicos, puede asegurarse de que su sitio permanezca bien optimizado y de manera eficiente.

Se invita a los autores contribuyentes a crear contenido para el terreno de los motores de búsqueda y se eligen por su experiencia y contribución a la comunidad de búsqueda. Nuestros contribuyentes trabajan bajo la supervisión del private editorial y las contribuciones se verifican en busca de calidad y relevancia para nuestros lectores. Las opiniones que expresan son las suyas.